分散型データで機械学習モデルを構築:通信コストを94%削減するFedAvg活用ガイド

分散型データでAIモデルを構築する際の課題を解決する鍵は、通信コストの削減です。 Federated Averaging (FedAvg) と勾配圧縮を組み合わせることで、通信オーバーヘッドを大幅に削減し、効率的な分散学習を実現できます。

Federated Averaging (FedAvg) とは?

FedAvgは、クライアント側でモデルをトレーニングし、その結果をサーバーに集約する分散型機械学習のアプローチです。中央サーバーにデータを集めることなく、各デバイス上のローカルデータを利用してモデルを学習させることができます。

FedAvgのメリット:

- プライバシー保護: ローカルデータはデバイス上に保持され、中央サーバーに送信されることはありません。

- 通信コスト削減: ローカルでの学習結果のみが送信されるため、データ自体を送信するよりも通信量が大幅に削減されます。

- 大規模データへの対応: 各デバイスがローカルで学習するため、大規模な分散データセットにも対応可能です。

勾配圧縮でさらなる効率化

FedAvgに加えて、勾配圧縮を適用することで、通信コストをさらに削減できます。勾配圧縮とは、モデルの更新情報(勾配)を送信する際に、そのサイズを縮小する技術です。

非IIDデータ、差分プライバシーへの対応

現実世界のデータは、しばしば独立同分布(IID)ではありません。FedAvgは、非IIDデータにも対応可能です。また、差分プライバシー(DP)を追加することで、より高度なプライバシー保護を実現できます。

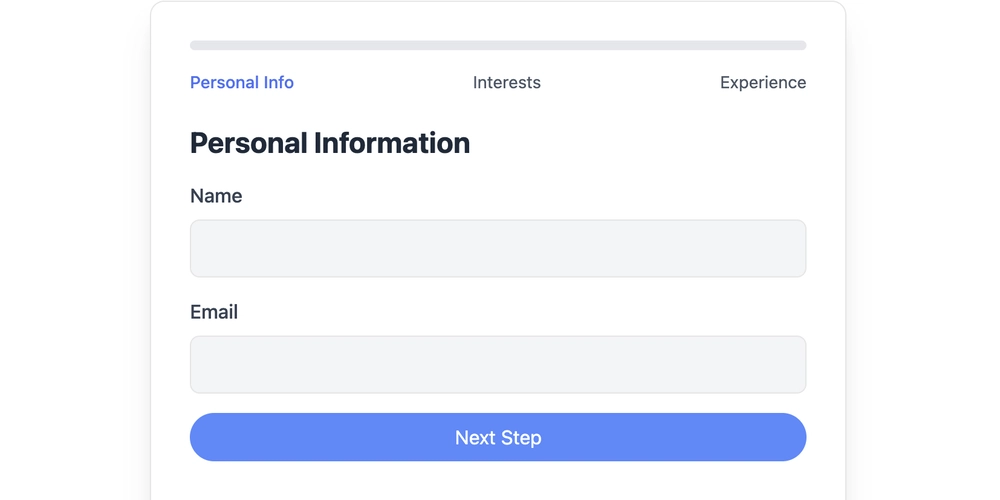

TensorFlow Federatedで実装

FedAvgは、TensorFlow Federated (TFF) を使用して簡単に実装できます。 TFFは、分散学習に必要な機能を備えたオープンソースのフレームワークです。初心者でも比較的簡単にFedAvgを実装し、分散学習を始めることができます。

分散型機械学習を始めよう

FedAvgは、分散型データで機械学習モデルを構築するための強力なツールです。通信コストを削減し、プライバシーを保護しながら、大規模データセットを活用できます。 TensorFlow Federatedを使えば、今日から分散型機械学習を始めることができます。分散型学習の効率化に貢献しましょう。

この記事が、FedAvgを活用した分散型機械学習の理解に役立つことを願っています。 TensorFlow Federatedを使って、非IIDデータで高性能なモデルを開発し、差分プライバシーでプライバシー保護も実現しましょう。